采集漫画网站是指通过编写特定的脚本或使用采集工具,自动化地从网站上抓取所需的漫画数据,这些数据包括但不限于漫画图片、标题、作者、简介等,以下是进行漫画网站采集的一些关键步骤和技术介绍:

了解目标网站结构和API

在开始采集之前,需要对目标漫画网站的网页结构进行分析,这通常涉及到查看网页源代码,理解其HTML结构,以及是否提供API接口,一些网站可能直接提供了API,这样可以更方便地获取数据。

选择合适的采集工具

市面上有许多不同类型的采集工具可供选择,包括浏览器扩展、桌面应用程序和在线服务,常见的有Scrapy、Octoparse、Import.io等,选择工具时要考虑其易用性、稳定性和能否满足特定需求。

编写采集规则

根据目标网站的结构,需要编写相应的采集规则,指定要抓取的数据路径和字段,在Scrapy中,你需要编写XPath或CSS选择器来提取数据。

数据存储

采集到的数据需要存储起来以便后续使用,常见的存储方式包括本地文件(如CSV、JSON)、数据库(如MySQL、MongoDB)等。

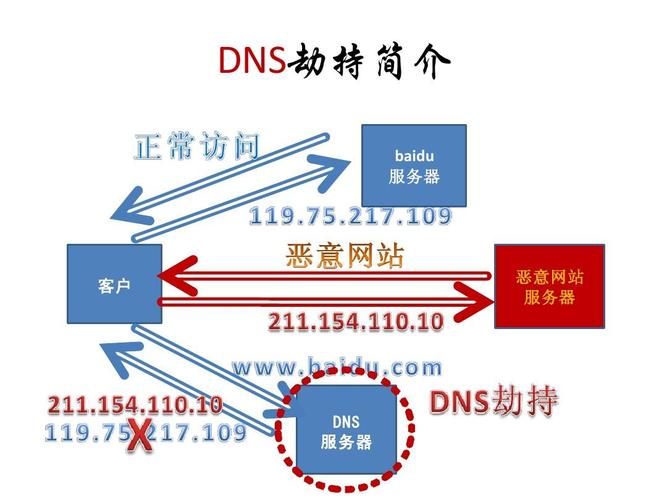

反爬虫机制处理

许多网站会采取反爬虫措施,如设置robots.txt、要求输入验证码、限制IP访问频率等,合理处理这些反爬机制是成功采集的关键。

遵守法律法规和道德准则

在进行数据采集时,必须尊重版权法和个人隐私,确保采集行为合法合规。

维护与监控

定期检查并维护采集脚本,以应对网站结构的变化或出现的错误,监控采集过程,确保数据的质量和采集的效率。

技术细节示例

单元表格:采集流程示例

| 步骤 | 描述 | 工具/方法 |

| 分析 | 研究目标网站的布局和元素 | 开发者工具 |

| 选择 | 根据需求选取合适的采集工具 | Scrapy、Octoparse |

| 编写 | 定制采集规则和路径选择器 | XPath、CSS选择器 |

| 存储 | 确定数据的存储格式和介质 | JSON、CSV文件 |

| 反爬 | 处理网站的反爬虫机制 | 代理IP、CAPTCHA解决 |

| 法规 | 确保符合相关法律和道德标准 | 自我审核 |

| 维护 | 定期检查和更新采集脚本 | 日志分析 |

相关问题与解答

Q1: 如果目标漫画网站经常更换布局,如何处理?

A1: 需要定期检查网站结构变化,并相应地更新采集规则,可以设立监控机制,比如定时检查关键元素是否存在,以确保采集脚本仍然有效。

Q2: 遇到需要登录才能访问的内容时怎么办?

A2: 需要模拟登录过程,获取并维持有效的登录状态(如Cookies或Session),这通常涉及到发送带有登录凭据的POST请求。

Q3: 如何避免因为频繁请求而被网站封禁?

A3: 可以使用代理服务器池来轮换IP地址,设置合理的请求间隔时间,并尽可能模仿人类用户的浏览行为。

Q4: 采集到的数据怎样处理才能提高效率?

A4: 根据需求进行数据清洗和格式化,使用批量处理和多线程技术来提高数据处理的速度,确保存储方案能够高效读写大量数据。