在VS2013中遇到CUDA报错,通常意味着在编译或运行CUDA程序时出现了问题,CUDA错误可能由多种原因引起,从硬件不兼容到代码逻辑错误,以下是针对提到的两个具体错误情况的分析和解决方案。

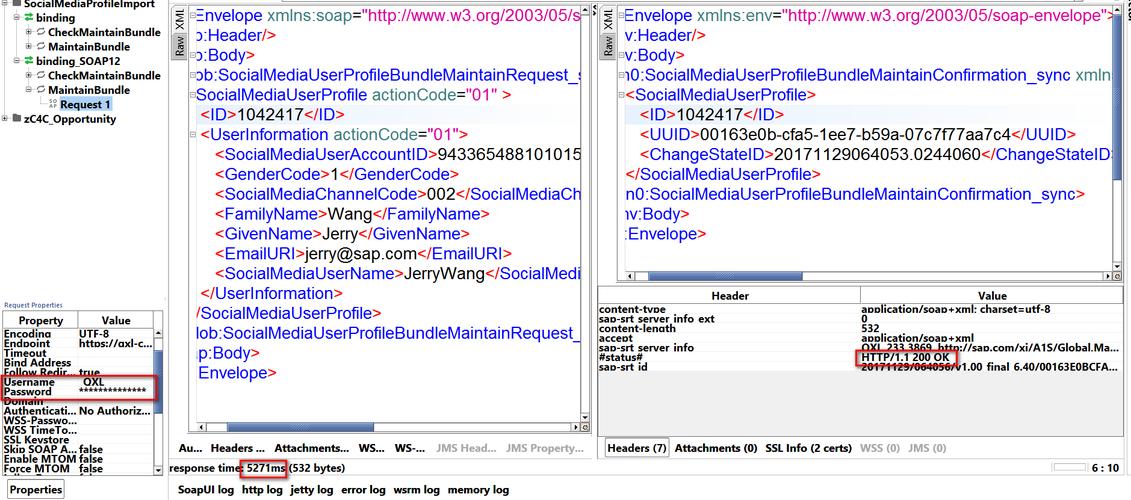

对于"RuntimeError: CUDA error: no kernel image is available for execution on the device"这个错误,它通常表明CUDA的运行时环境无法找到适合当前设备(例如NVIDIA GPU)的编译后的kernel图像,以下是关于此问题的详细解析:

1、版本不匹配问题:如参考信息[1]所述,当安装的PyTorch版本与系统CUDA版本不兼容时,可能会出现这种错误,Anaconda环境虽然方便管理不同版本的库,但版本兼容性问题仍需特别注意。

解决方法:确保PyTorch、TorchVision和CUDA Toolkit版本之间的匹配,这通常可以通过PyTorch官方网站提供的版本对应表来完成,如果系统中的CUDA版本因其他框架(如PaddlePaddle)而变得不匹配,需要重新安装正确版本的PyTorch。

2、安装适合的PyTorch版本:如果通过conda命令无法直接安装匹配的PyTorch版本,可以尝试以下方法:

从源代码编译PyTorch,这是一个较为复杂的步骤,但允许用户针对特定的CUDA版本和硬件架构进行编译。

使用与当前CUDA版本相近的PyTorch版本,并利用其向下兼容的特性。

3、确认CUDA驱动和GPU支持:有时,问题可能不在于PyTorch,而在于CUDA驱动程序与GPU硬件之间的兼容性,需要确认驱动程序是最新的,并且与安装的CUDA Toolkit版本兼容。

对于第二个错误,关于CUDA编程中原子操作atomicAdd的问题:

1、错误原因:如参考信息[2]中所述,当尝试在计算能力较低(小于6.0)的设备上使用双精度浮点数(double)原子操作时,会遇到编译错误。

2、解决方案:可以通过判断CUDA架构的版本,如果低于6.0,则需要使用一个替代的原子操作函数,这是因为低版本的CUDA架构不支持直接的双精度原子操作。

替代原子操作函数:可以通过使用一系列的原子操作实现一个适用于低版本CUDA架构的双精度原子操作函数,将双精度浮点数分解为两个32位整数,分别进行原子操作,然后再合成。

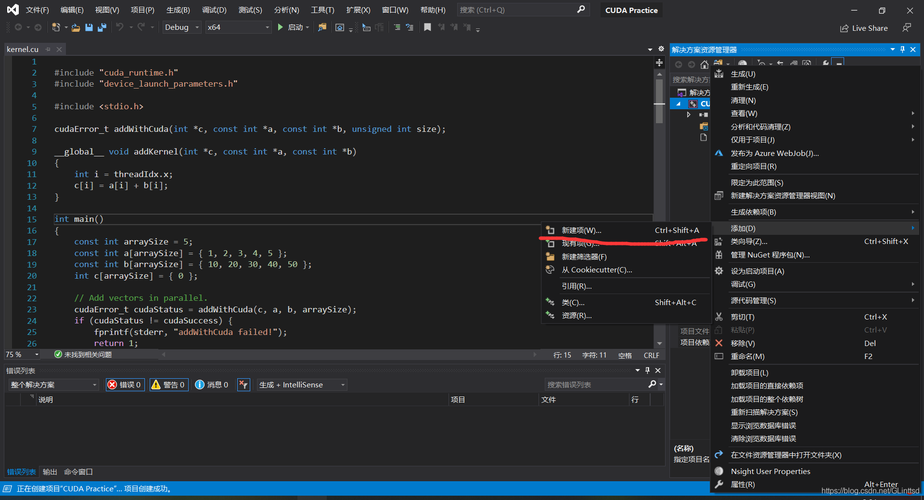

以下是一个可能的替代原子操作的实现:

#if CUDA_ARCH < 600 __device__ double atomicAdd(double* address, double val) { unsigned long long int* address_as_ull = (unsigned long long int*)address; unsigned long long int old = *address_as_ull, assumed; do { assumed = old; old = atomicCAS(address_as_ull, assumed, __double_as_longlong(val + __longlong_as_double(assumed))); // Note: uses integer comparison to avoid hang in case of ties } while (assumed != old); return __longlong_as_double(old); } #endif请注意,以上代码需要在包含它的源文件中定义CUDA_ARCH,以确保正确的预处理器分支。

总结而言,在VS2013或任何CUDA开发环境中,解决报错的关键步骤包括:

核实版本兼容性:确保CUDA、PyTorch、TorchVision等库之间的版本相互兼容。

检查硬件支持:确认GPU的计算能力和CUDA驱动程序版本。

使用适当的方法:对于不支持的硬件功能,使用替代方案,如低版本CUDA架构下的双精度原子操作函数。

通过这些方法,开发者通常可以解决在VS2013中遇到的CUDA相关报错问题。