在处理ORC(Optimized Row Columnar)文件时,你可能会遇到一些报错问题,ORC文件是一种高效的数据存储格式,通常用于Hadoop生态系统中的数据处理,以下是关于ORC文件写出(写入)过程中可能出现的报错及其解决方案的详细描述。

常见报错及原因:

1、ClassNotFoundException:

当运行含有ORC文件写出操作的程序时,如果相应的ORC库没有添加到项目的类路径(classpath)中,会出现这个错误,你需要确保项目中包含了所有必要的ORC依赖。

2、IOException:

写出ORC文件时可能由于各种原因(如文件权限问题、磁盘空间不足、网络问题等)导致IOException,解决这类问题通常需要检查文件系统状态和权限。

3、UnsupportedOperationException:

如果你在写出操作中使用了ORC格式不支持的功能,如某些复杂的数据类型或压缩选项,可能会抛出此异常。

4、InvalidInputException:

当提供的数据格式或类型与ORC要求的格式不匹配时,将出现此错误,试图将非基本类型的数据写入ORC文件。

5、HiveException:

如果在使用Hive与ORC文件交互时发生错误,可能会抛出HiveException,这通常与Hive的配置或元数据有关。

报错处理和解决方案:

1、确保依赖正确:

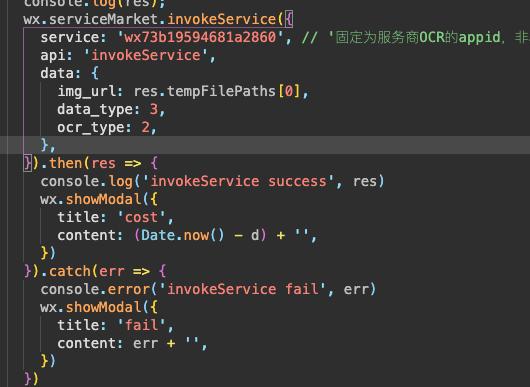

首先检查项目的依赖配置,确保包含了如Apache ORC、Hadoop等必要的库,以Maven为例,可以在pom.xml文件中添加以下依赖:

“`xml

<dependency>

<groupId>org.apache.orc</groupId>

<artifactId>orccore</artifactId>

<version>版本号</version>

</dependency>

“`

2、检查文件系统权限:

如果出现文件权限问题,需要检查输出目录的读写权限,对于HDFS,确保你的Hadoop用户有足够的权限来创建和写入文件。

3、磁盘空间和资源检查:

如果出现由于磁盘空间不足或资源限制导致的IOException,需要检查存储系统的状态,并释放空间或增加资源。

4、兼容性检查:

如果使用了不支持的特性,需要检查ORC的官方文档,确保你的写出操作符合支持的特性列表。

5、数据类型匹配:

在写出数据之前,检查数据类型是否与ORC支持的数据类型匹配,如果使用的是自定义数据类型,需要确保已经正确实现了相应的序列化和反序列化方法。

6、配置检查:

如果使用Hive,检查hivesite.xml中的配置是否正确,特别是与存储格式、压缩相关的设置。

7、查看日志文件:

大多数错误都会在日志文件中有详细描述,检查Hadoop、Hive或应用程序日志,可以获取错误栈跟踪,这有助于诊断问题。

8、示例代码审查:

审查你的代码,检查是否有以下问题:

使用了正确的API来创建和写出ORC文件。

检查是否有正确的错误处理逻辑。

确保数据在写出之前已经被正确处理和转换。

9、使用最新的稳定版:

确保使用的ORC库版本是最新的稳定版本,旧版本可能包含一些已知的问题或限制。

10、社区和文档资源:

如果以上方法都不能解决问题,可以考虑查看ORC的官方文档,或者参与社区讨论,一些特定的问题可能在社区中已经有了解决方案。

通过以上步骤,你应该能够定位和解决大多数与ORC文件写出相关的报错问题,需要注意的是,处理这类问题通常需要详细查看错误信息,并理解背后的原理,以便能够采取正确的解决措施。